Dans une étude récente, le linguiste François Pellegrino a montré que, quel que soit le débit de parole propre à chaque langue et chaque locuteur, le débit moyen d’information, lui, reste sensiblement le même : 39 bits par seconde. Comment lier cette valeur universelle avec la synchronisation des rythmes cérébraux sur la parole, s’interroge Véronique Boulenger avec son approche de neuroscientifique ?

Il n’est plus étonnant de voir des recherches en neurosciences dans un laboratoire de linguistique tant l’apport des neurosciences en sciences du langage est important. Les premiers rapprochements entre ces deux disciplines viennent des études sur l’acquisition et les pathologies du langage. Avec les découvertes, à la fin du XIXe siècle, des aires de Broca et de Wernicke, nous avons compris par exemple que des lésions dans ces aires du cerveau peuvent produire des formes d’aphasie différentes (perte partielle ou totale de la faculté de s’exprimer ou de comprendre). Aujourd’hui, les travaux de François Pellegrino et Véronique Boulenger, tous deux chercheurs au laboratoire Dynamique du Langage (DDL), contribuent à mieux comprendre les mécanismes cérébraux impliqués dans la compréhension du langage et lèvent le voile sur leur lien avec le débit moyen de parole adopté par des locuteurs de différentes langues.

La parole à la recherche d’efficacité

François Pellegrino est l’un des co-auteurs d’une étude remarquée parue en septembre 2019 s’intéressant aux différences entre les langues pour coder et transmettre l’information. Pour ce faire, il a demandé à des locuteurs natifs de 17 langues de produire une quinzaine d’énoncés chacun, puis a calculé leur débit d’information. 17 langues, c’est évidemment peu par rapport aux milliers de langues parlées dans le monde, mais leur choix ne s’est pas fait au hasard : de l’allemand au finnois, de l’italien au coréen, du français au hongrois, il permet de disposer d’une variété assez importante. Ces langues appartiennent à neuf familles différentes disséminées en Europe et en Asie et représentent un échantillon diversifié en termes de grammaires, de systèmes de sons, etc.

De l’allemand au finnois, de l’italien au coréen, du français au hongrois, un choix de 17 langues appartenant à neuf familles différentes disséminées en Europe et en Asie

Le protocole expérimental était relativement simple : « Nous sommes partis de corpus traduits dans chaque langue, donc d’un même contenu informationnel », précise François Pellegrino. Les locuteurs se familiarisaient avec les textes puis les lisaient à voix haute trois fois, la deuxième répétition étant analysée. En parallèle, on calculait la quantité moyenne d’information portée par syllabe.

L’étude révèle que s’il existe des variations dans la quantité d’information encodée dans chaque langue, elles sont compensées par le débit de parole. En effet, si on compare les 17 langues en termes d’encodage (information par syllabe) et de débit de parole, elles sont assez variées. Cependant, en termes de débit d’information, elles sont assez similaires et tendent à se rapprocher d’un débit moyen de 39 bits par seconde. Cette valeur correspond au produit entre le nombre de syllabes prononcées par minute et la quantité d’information par syllabe : il pourrait refléter une valeur optimale pour le traitement de la parole.

En pratique, les langues qui se parlent vite ont tendance à diluer l’information sur plus de syllabes, tandis que les langues plus lentes contiennent plus d’information en peu de syllabes. Les chercheurs font l’hypothèse que cette optimisation résulte d’un compromis entre des contraintes de mémorisation des énoncés et de charge cognitive élevée dans le traitement temps réel lorsque le débit de parole est trop rapide.

Cette optimisation du débit d’information autour de 39 bits par seconde semble donc universelle et serait liée à nos capacités cognitives.

Ce qui est vrai pour des langues différentes l’est également pour des situations ou des locuteurs différents. C’est-à-dire qu’en fonction du contexte et des individus en interaction, nous adaptons notre débit de parole pour que notre interlocuteur comprenne l’énoncé. « Les locuteurs les plus rapides vont utiliser un langage plus simple, des mots plus facilement accessibles et des structures syntaxiques plus simples », précise François Pellegrino, en faisant référence à une étude publiée par le chercheur Uriel Cohen Priva en 2017. C’est ainsi qu’on retrouve dans les médias audiovisuels des débits d’information et des tournures de phrases qui cherchent l’équilibre entre la compréhension et l’intérêt. Si le débit d’information n’est pas adapté à la situation, alors l’interlocuteur décroche. Cette optimisation du débit d’information semble donc universelle et serait liée à nos capacités cognitives.

Le cerveau et le langage sur le même tempo

Véronique Boulenger, également du laboratoire Dynamique du Langage, mène pour sa part des recherches sur les substrats cérébraux de la perception de la parole à l’aide de la neuro-imagerie. Dans ses expérimentations en magnétoencéphalographie (MEG), elle fait varier le débit syllabique de phrases entendues par des participants et étudie la capacité de leur cerveau à s’ajuster pour continuer à se synchroniser sur la vitesse de parole de l’interlocuteur. « Écouter de la parole accélérée a un coût cognitif important et recrute davantage d’aires cérébrales, explique-t-elle. C’est encore plus vrai lorsque l’accélération est naturelle plutôt qu’artificielle, puisqu’elle engendre des changements articulatoires importants. » Ainsi, écouter de la parole naturellement produite à un débit rapide sollicite notamment les régions motrices du cerveau.

On sait que la parole est un signal quasi-rythmique et relativement prédictible, par exemple avec les syllabes accentuées qui présentent une régularité temporelle. Ainsi, en français, la dernière syllabe d’un groupe rythmique est accentuée, elle est plus longue. Le cerveau possède lui aussi une activité rythmique, c’est ce qu’on appelle les oscillations cérébrales qui sont mesurées en électroencéphalographie (EEG) et en MEG. Il s’agit de variations électromagnétiques de l’excitabilité neuronale qui se produisent dans des bandes de fréquence différentes.

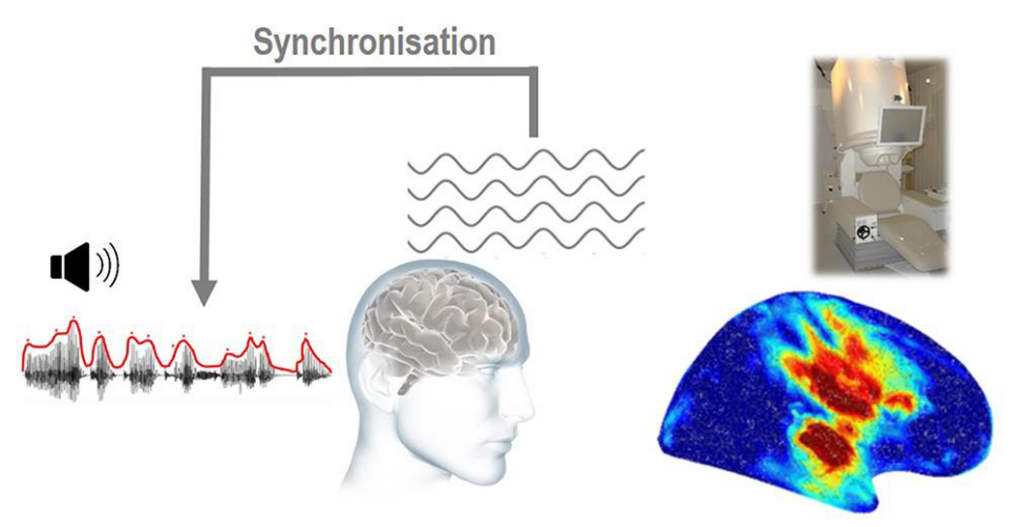

Comment le cerveau se synchronise sur le rythme de la parole

Les rythmes du cerveau, appelés oscillations cérébrales, se synchronisent sur le rythme de la parole. Ceci va permettre de découper le flux continu de parole en « paquets » d’information de la taille des syllabes et des mots, et donc faciliter la compréhension. Le rythme de la parole est principalement donné par les modulations lentes que l’on retrouve dans l’enveloppe d’amplitude du signal (ici en rouge) et qui reflètent le rythme syllabique. À droite, une carte du cerveau (hémisphère droit) illustrant le couplage cerveau/parole, mesuré à l’aide de la magnétoencéphalographie (MEG), lors de l’écoute de phrases en français. La synchronisation entre les oscillations cérébrales et le rythme syllabique se produit dans le cortex auditif et les régions motrices.

Les rythmes du cerveau, appelés oscillations cérébrales, se synchronisent sur le rythme de la parole. Ceci va permettre de découper le flux continu de parole en « paquets » d’information de la taille des syllabes et des mots, et donc faciliter la compréhension. Le rythme de la parole est principalement donné par les modulations lentes que l’on retrouve dans l’enveloppe d’amplitude du signal (ici en rouge) et qui reflètent le rythme syllabique. À droite, une carte du cerveau (hémisphère droit) illustrant le couplage cerveau/parole, mesuré à l’aide de la magnétoencéphalographie (MEG), lors de l’écoute de phrases en français. La synchronisation entre les oscillations cérébrales et le rythme syllabique se produit dans le cortex auditif et les régions motrices.

Les modèles récents montrent que ces oscillations sont capables de se synchroniser sur la structure rythmique de la parole, en particulier dans la bande de fréquence thêta (comprise entre 4 et 7 Hertz). Ce couplage entre rythmes du cerveau et rythme de la parole permettrait au cerveau de découper plus facilement le flux continu de parole en « paquets » d’information de la taille des syllabes et des mots, ce qui faciliterait la compréhension du message. Des études montrent d’ailleurs qu’une mauvaise synchronisation entre les oscillations cérébrales de l’auditeur et le rythme de parole de son interlocuteur entrave l’intelligibilité.

Cependant, tout comme pour le débit de parole, il existe beaucoup de variations interindividuelles, en partie liées au vécu de chacun, qui influencent la façon dont le cerveau fonctionne.

Les similitudes observées entre rythmes du langage et rythmes cérébraux et l’existence d’un débit d’information préférentiel de 39 bits/seconde traduisent-ils une adaptation des langues au fonctionnement du cerveau, voire du cerveau aux langues ? Il est trop tôt pour le dire. Les études sur le débit d’information et les oscillations cérébrales vont s’enrichir progressivement de nouvelles données. Les chercheurs entrevoient notamment des pistes de recherche sur la langue des signes, les modes de communication animale ou encore sur les oscillations cérébrales chez les individus bilingues ou les enfants présentant un trouble développemental du langage.

Sur le même sujet

Pour comprendre ce qu’il se passe dans notre cerveau, il faut parfois savoir payer de sa personne. C’est ainsi que je me suis retrouvé avec un casque à électrodes sur la tête à écouter des séquences bizarres alternant rythmes et textes lus. Objectif de l’expérience : comprendre pourquoi notre cerveau est meilleur pour traiter le langage après une amorce rythmique. Anna, la post-doctorante qui mène l’étude, m’a expliqué que c’était dû à une synchronisation de l’activité des neurones avec le rythme perçu. Et que ça se voyait ! Lire l’article.